Menulis Robots.txt Untuk SEO (Untuk Amatur)

Ia hanyalah satu fail teks kecil, tersembunyi di dalam direktori utama landing page anda. Namanya robots.txt. Namun, satu kesilapan kecil dalam fail ini, satu baris kod yang salah, boleh menyebabkan keseluruhan landing page anda hilang dari radar Google dalam sekelip mata. Ini bukan drama, ini adalah realiti teknikal SEO.

Ramai SEO Specialist dan webmaster di Malaysia, sama ada yang baru atau berpengalaman mempunyai stigma terhadap fail ini. Ada yang takut untuk menyentuhnya bimbang akan akibat yang tidak dijangka. Ada pula yang menyalahgunakannya, cuba menggunakan arahan Disallow untuk menghalang pengindeksan website, satu kesilapan fatal yang sering berlaku. Yang paling biasa, mereka membiarkannya kosong atau tidak wujud, lantas membiarkan Googlebot merayau bebas dan membazirkan bajet merangkak (crawl budget) yang berharga pada website yang tidak penting.

Secara ringkasnya, panduan ini dicipta untuk merungkai misteri di sebalik menulis robots.txt untuk SEO. Kita akan belajar dari asas sehinggalah kepada strategi lanjutan untuk menjadikan fail kecil ini sebagai alat kawalan trafik enjin carian yang paling berkuasa untuk anda.

“Fail robots.txt adalah untuk menguruskan trafik perangkak, bukan untuk menghalang pengindeksan. Jika anda mahu sesuatu website tidak diindeks, gunakan meta tag noindex.” – John Mueller, Google Search Advocate

1. Apa Sebenarnya Fail Robots.txt?

Fikirkan fail robots.txt sebagai seorang penyambut tetamu atau pengawal keselamatan di lobi bangunan anda (landing page anda). Apabila perangkak enjin carian (seperti Googlebot) tiba, ia akan “bertanya” kepada penyambut tetamu ini terlebih dahulu: “Kawasan mana yang boleh saya lawati, dan kawasan mana yang terlarang?”

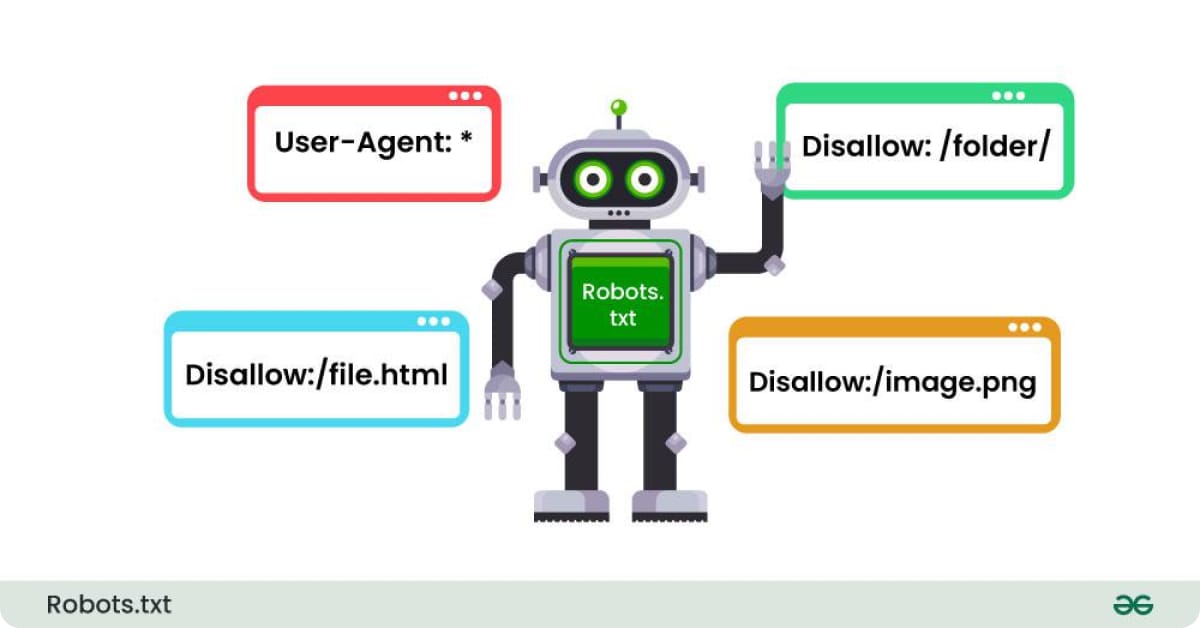

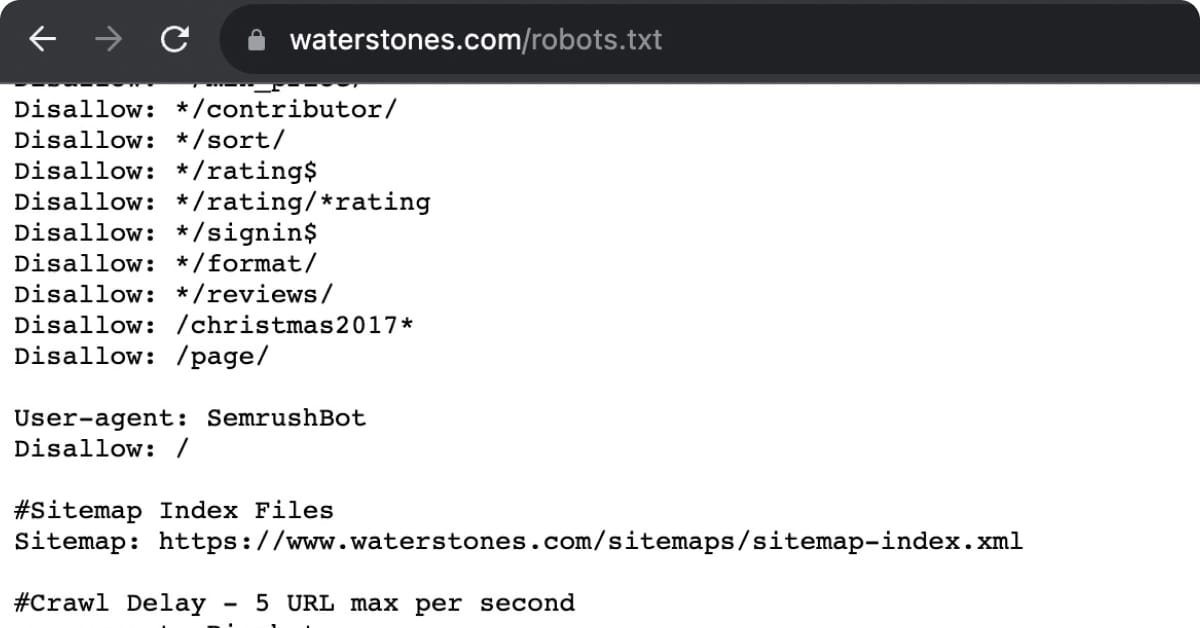

Fail ini menggunakan beberapa arahan mudah yang dipanggil directives untuk memberi arahan. Dua yang paling utama ialah:

- User-agent: Ini merujuk kepada perangkak spesifik yang anda ingin beri arahan.

User-agent: *bermaksud arahan ini terpakai kepada semua perangkak.User-agent: Googlebotpula khusus untuk perangkak Google sahaja. - Disallow: Arahan ini memberitahu perangkak untuk tidak memasuki atau merangkak fail atau direktori tertentu. Contohnya,

Disallow: /pentadbir/memberitahu bot untuk tidak memasuki folder pentadbir anda.

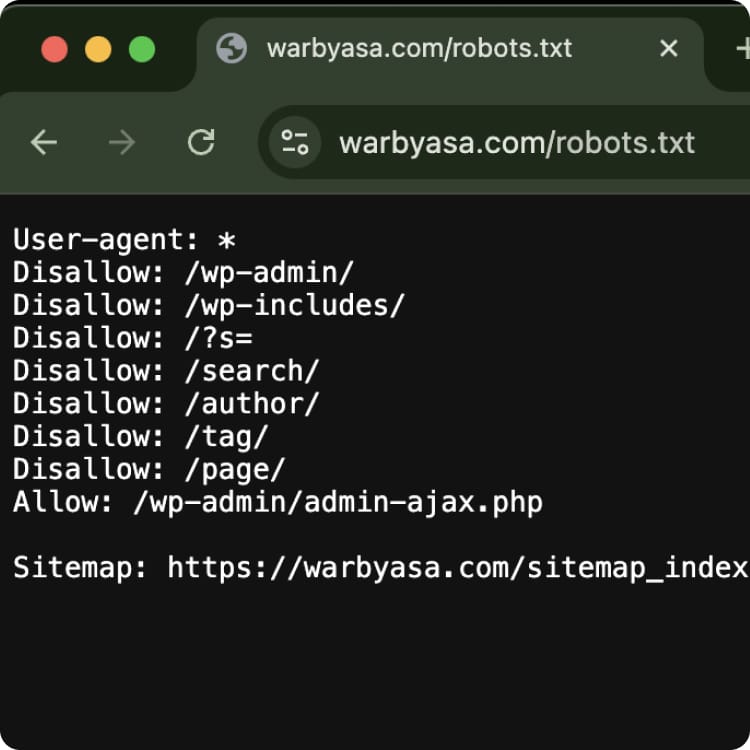

Contoh fail robots.txt yang sangat asas :-

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

Sitemap: https://landingpageanda.com/sitemap.xml2. Kenapa Menulis Robots.txt Penting?

Walaupun ia tidak secara langsung meningkatkan ranking anda, pengurusan robots.txt yang betul adalah asas kepada SEO teknikal yang sihat.

- Pengurusan Bajet Merangkak: Setiap landing page mempunyai “bajet merangkak” yang terhad. Anda mahu Googlebot menghabiskan masa dan sumbernya untuk merangkak website penting anda (produk, artikel blog, perkhidmatan) dan bukan website yang tidak bernilai SEO seperti website ‘terima kasih’, hasil carian dalaman, atau akaun pengguna.

- Menghalang Akses ke Kawasan Sulit: Anda pastinya tidak mahu bahagian pentadbiran, fail konfigurasi, atau website troli beli belah anda dirangkak.

robots.txtadalah barisan pertahanan pertama untuk menghalangnya. - Mengelakkan Beban Pelayan (Server Overload): Perangkak yang agresif boleh membebankan pelayan anda.

robots.txtboleh digunakan untuk memperlahankan kadar rangkakan jika perlu, walaupun ini jarang diperlukan untuk kebanyakan landing page.

Baca : Apa Itu Pagination Dalam SEO? Ini Penjelasan Kami (2026)

3. Bila Masa Yang Tepat Untuk Menggunakannya?

Anda tidak semestinya perlukan fail robots.txt yang rumit. Namun, dalam beberapa senario, ia sangat kritikal:

- Apabila Anda Mempunyai Kawasan Pentadbiran: Seperti direktori

/wp-admin/dalam WordPress. Anda wajib menghalangnya. - Apabila Landing Page Anda Mempunyai Fungsi Carian: Hasil carian dalaman (

/?s=carian-anda) boleh mencipta ribuan website berkualiti rendah. Halang direktori carian ini. - Apabila Anda Mempunyai Landing Page Pementasan (Staging): Sebelum melancarkan landing page baru, anda pasti tidak mahu versi percubaan diindeks. Gunakan

Disallow: /pada staging server. - Apabila Terdapat Parameter URL: Jika landing page anda menjana URL dengan parameter yang tidak mengubah kandungan (seperti ID sesi), anda boleh menghalangnya untuk mengelakkan kandungan pendua.

4. Di Mana Nak Cari dan Betulkan Fail Ini?

Fail robots.txt mesti diletakkan di dalam direktori root (akar) domain anda. Anda sepatutnya boleh mengaksesnya melalui https://landingpageanda.com/robots.txt.

Cara mencipta atau mengeditnya :-

- Buka aplikasi teks biasa seperti Notepad (Windows) atau TextEdit (Mac). Elakkan dari menggunakan Microsoft Word.

- Tulis arahan anda. Mulakan dengan fail yang ringkas.

- Simpan fail tersebut dengan nama

robots.txt. - Gunakan klien FTP (seperti FileZilla) atau pengurus fail (File Manager) dalam cPanel hosting anda untuk memuat naik fail ini ke direktori utama (biasanya

public_html).

Sebelum memuat naiknya, anda amat digalakkan untuk menguji fail anda menggunakan Robots.txt Tester di dalam Google Search Console.

Baca : Apa Itu Canonical Dalam SEO? Ini Penjelasan Dari Kami

5. Bagaimana Ia Meningkatkan Prestasi SEO?

Secara tidak langsung, robots.txt yang dioptimumkan membantu SEO anda dengan:

- Memfokuskan Usaha Google: Dengan menghalang kandungan tidak penting, anda memaksa Googlebot untuk menumpukan perhatian pada website yang benar benar anda mahu diberi kedudukan.

- Mempercepatkan Pengindeksan: Apabila bajet merangkak digunakan dengan efisien, Googlebot dapat menemui dan mengindeks kandungan baru anda dengan lebih pantas.

- Memperbaiki Kesihatan Teknikal Landing Page: Ia menghalang Google daripada menemui ribuan URL berkualiti rendah yang boleh menjejaskan persepsi kualiti keseluruhan landing page anda.

“Satu perkara penting untuk diingat tentang robots.txt adalah, walaupun anda menghalang URL, kami masih boleh mengindeksnya jika kami menemuinya melalui pautan dari tempat lain. Kami hanya tidak akan merangkaknya. Untuk jaminan tidak diindeks, guna noindex.” – Danny Sullivan, Google Search Liaison

Kesimpulan

Secara keseluruhannya, fail robots.txt bukanlah sesuatu yang perlu digeruni. Ia adalah alat komunikasi yang jelas dan berkuasa antara anda dan enjin carian. Kemahiran menulis robots.txt untuk SEO yang betul adalah tanda seorang pakar SEO teknikal yang matang, yang faham bahawa pengurusan sumber adalah sama pentingnya dengan penciptaan kandungan. Ia memastikan asas landing page anda kukuh dan sedia untuk dirangkak dengan paling efisien.

Kesilapan kecil dalam fail ini boleh membawa padah yang besar, menjejaskan trafik dan pendapatan anda. Jika anda tidak pasti atau bimbang tentang konfigurasi fail robots.txt anda, jangan ambil risiko.